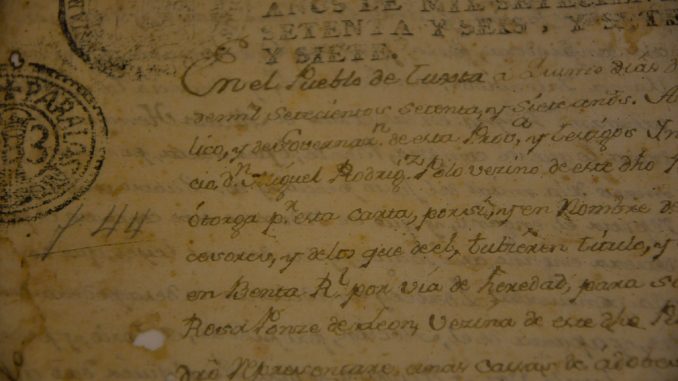

Os documentos históricos presentes em bibliotecas e universidades são de extrema importância para o estudo de diversas áreas. Muitos deles, porém, estão impossibilitados de serem analisados com maior profundidade e comparados uns aos outros por meio de softwares. Isso ocorre, por exemplo, devido a tipografias diferentes e ao desgaste causado pelo tempo. Pensando nisso, o pesquisador Gustavo Salazar, orientado pelo professor Alair Pereira, propôs um sistema de reconhecimento de documentos históricos que busca contornar esses problemas. Sua tese de doutorado foi apresentada ao Instituto de Matemática e Estatística da Universidade de São Paulo (IME-USP).

Os textos contêm diversas particularidades específicas causadas pelo tempo que dificultam a ação do computador ao identificar aqueles caracteres. “Em sua maioria, são textos impressos, mas a tipografia é diferente, a própria imagem é ruim e a forma de escanear a imagem foi feita de maneira errada, pois a qualidade influencia também”, exemplifica o pesquisador. “Fora isso tem o problema da língua. O latim do século XIII não é igual ao latim do século XV, o que não é necessariamente um erro, mas constitui uma dificuldade para a identificação”.

O problema de reconhecimento de caracteres tem sido debatido principalmente devido à realização de uma grande quantidade de conferências na área de humanidades digitais. “Existem muitos livros antigos no Google Books, por exemplo, em que só há imagem. E existe todo um movimento para poder preservar essa cultura, essa herança cultural”, diz Salazar.

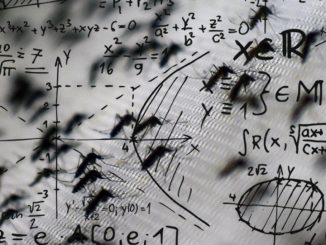

Segundo o pesquisador, ele e o orientador perceberam que as estratégias utilizadas não eram as melhores, então propuseram usar técnicas da bioinformática para solucionar o problema. “Uma das questões que a gente observou é que os sistemas de reconhecimento de caracteres não são muito bons com esses tipos de livros porque a tipografia é antiga”, explica ele. “Do outro lado, dado que não se consegue ter o texto limpo, é difícil encontrar trechos em comum ou descobrir quem é autor de um trecho. Então a gente construiu algoritmos, um sistema web em cima disso para que as pessoas possam fazer esse trabalho”.

Atualmente, o sistema utilizado para o reconhecimento de texto é feito de forma manual, sendo esse um dos principais dificultadores do trabalho. “Basicamente o que se faz é pegar um desses sistemas que já estão prontos, treinar manualmente, e repetir esse fluxo. A limitação é que isso deve ser realizado manualmente. Fazer isso para um livro de 500 páginas do século XIV se torna muito difícil, ocupa muito tempo, ainda mais por serem centenas de livros”, afirma Salazar.

Salazar oferece um exemplo prático do problema: a segmentação de caracteres. Ao fazer o reconhecimento de um texto, o software deve separar um caractere do outro. Às vezes, devido às limitações citadas anteriormente, algumas letras acabam “grudadas”. Nesse caso, deve haver um modelo pré treinado que informe o software para separar esses caracteres. São muitos os casos diferentes e possíveis em que isso pode acontecer, o que torna impraticável a correção de todos os problemas dessa forma.

O sistema proposto pelo pesquisador utiliza técnicas da bioinformática e permite fazer reconhecimento, busca aproximada e alinhamento múltiplo dos textos. A busca aproximada permite a identificação de padrões e termos semelhantes em diferentes textos para que seja possível fazer o alinhamento múltiplo. Esse último termo significa comparar dois ou mais textos verificando frases iguais ou semelhantes entre eles, ajudando no reconhecimento do real autor de determinado trecho ou ideia. Os sistemas atuais só permitem fazer o alinhamento de até dois textos.

As principais vantagens do sistema proposto são a facilidade e a rapidez. “É uma coisa que se é feito manualmente demora muito tempo. Tem uma pessoa que ficou 15 anos fazendo alinhamento dos evangelhos sinópticos. Outro demorou 20 anos pra fazer o alinhamento dos textos dos filósofos pré socráticos. Eu faço isso em questão de minutos com essa ferramenta”, afirma Salazar.

O projeto ainda espera maiores financiamentos para seguir em frente e abrir a plataforma para o público. Os algoritmos usados no sistema ainda estão sendo publicados, mas há a intenção de tornar seu código aberto. A pesquisa, porém, já apresenta resultados concretos. Com o sistema criado, foi possível identificar o verdadeiro autor de uma profecia comunicada por São Francisco, por meio da comparação entre textos de diferentes séculos. “Isso é uma coisa que os historiadores sabiam, mas que de fato não havia evidência. Foi muito interessante porque ninguém fez isso, dá uma confirmação se de fato foi ele quem falou aquilo. Foi a descoberta mais legal do nosso trabalho”, diz o pesquisador.

Outro aspecto interessante da pesquisa está na interdisciplinaridade de temas. Por esse motivo, o projeto está a procura de alunos de diferentes áreas interessados no reconhecimento e alinhamento de documentos históricos e na parte computacional. “Na biblioteca Brasiliana, [o sistema] poderia ser usado. Imagine poder entrar na Brasiliana e alinhar os textos de determinado autor do século XV. Para a área de humanas isso seria muito legal”, afirma Salazar. “A gente fez testes, experimentos em detecção de plágios, e o resultado foi bem interessante. Deu outras ideias pra estender também além da similaridade com erros entre as palavras, como colocar a similaridade por dicionários, e é uma coisa que a gente também pretende trabalhar no futuro. Então ainda tem muita coisa para ser feita, mas a gente está procurando gente que nos possa apoiar para continuar o trabalho”.

Faça um comentário